为开发者而生的

AI 工作流平台

无需学习新概念,像往常一样编写函数、引用代码库即可生成节点;拖放组合成工作流,高效创造新功能,并支持 API、MCP 工具或自动化程序对外发布,让想法瞬间变为产品。

四大核心功能

从开发到部署,全链路提效

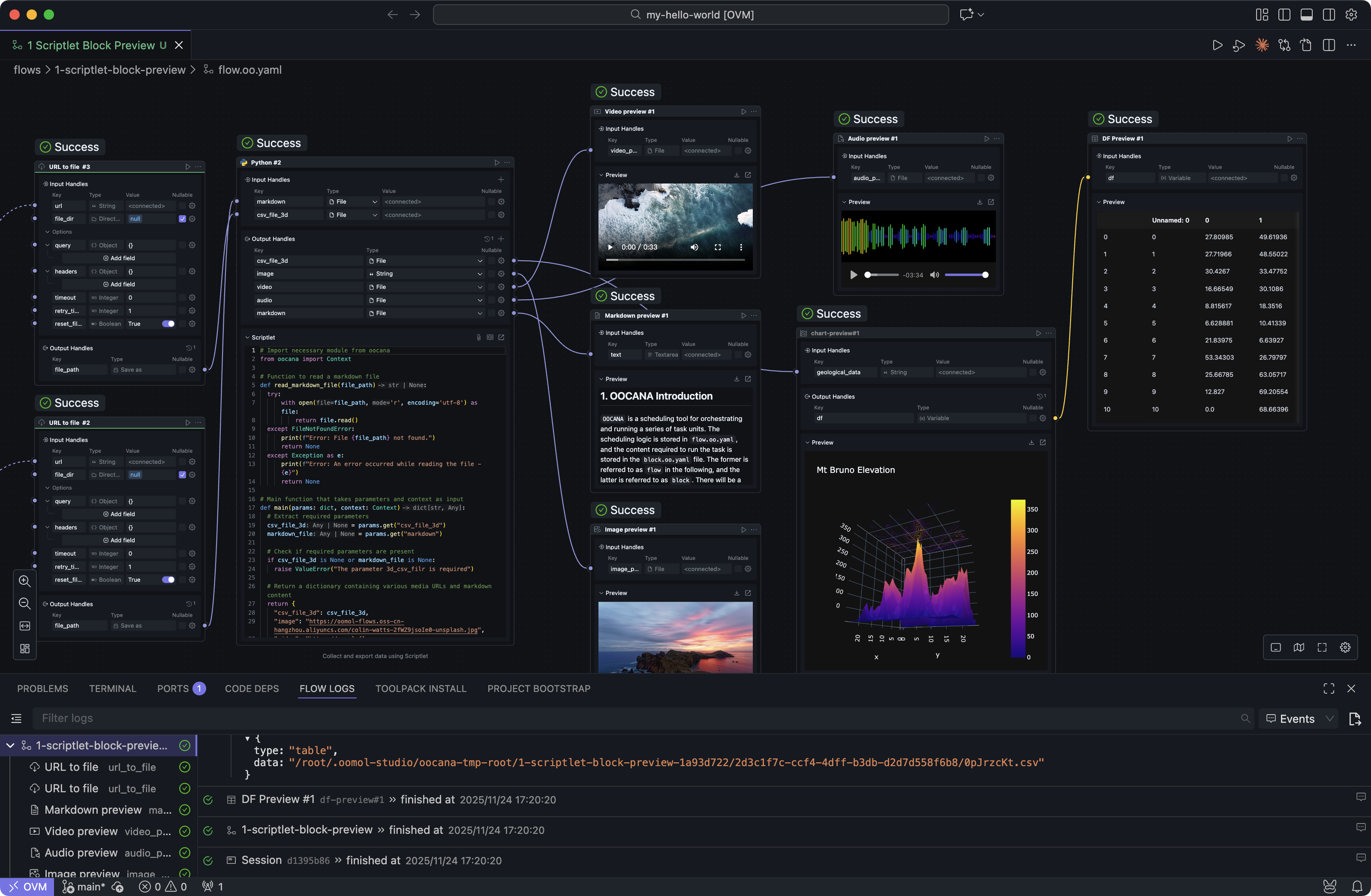

01|节点即函数:不学新框架,直接上手

在 oomol,节点就是函数。你写的每一行代码,都可以成为能力组件。

• 入参/出参清晰定义,对外调用像使用 API 一样简单

• 引用任意开源库,功能扩展零瓶颈

• VSCode 原生体验

• AI 自动生成节点 + Vibe Coding Block 加速开发

• 入参/出参清晰定义,对外调用像使用 API 一样简单

• 引用任意开源库,功能扩展零瓶颈

• VSCode 原生体验

• AI 自动生成节点 + Vibe Coding Block 加速开发

✨熟悉的方式,不设天花板的能力

02|本地容器化开发:生产即部署

IDE 内置容器环境,随时启用。

• 免环境搭建,开箱即用

• 强隔离,不污染宿主机

• 本地环境与云端环境完全一致

• 免环境搭建,开箱即用

• 强隔离,不污染宿主机

• 本地环境与云端环境完全一致

✨写完就能上云,不再 Debug "环境不一致"问题

03|设备即服务器:让闲置算力上岗

结合容器与反代技术,为设备直接分配域名。

• 个人电脑 & NAS 秒变服务器

• GPU 价值不再浪费(支持 WSL2 调用 Nvidia GPU)

• 私有部署 + 随时远程访问

• 个人电脑 & NAS 秒变服务器

• GPU 价值不再浪费(支持 WSL2 调用 Nvidia GPU)

• 私有部署 + 随时远程访问

✨把你所有的设备变成开发资源

04|一键发布:API / MCP / 自动化程序

工作流与节点均可发布为可调用的能力:

• Serverless API 服务

• MCP 工具,直接接入 AI

• 定时器 / Trigger 自动化流程

• Serverless API 服务

• MCP 工具,直接接入 AI

• 定时器 / Trigger 自动化流程

✨写出能力,就能被任何系统使用

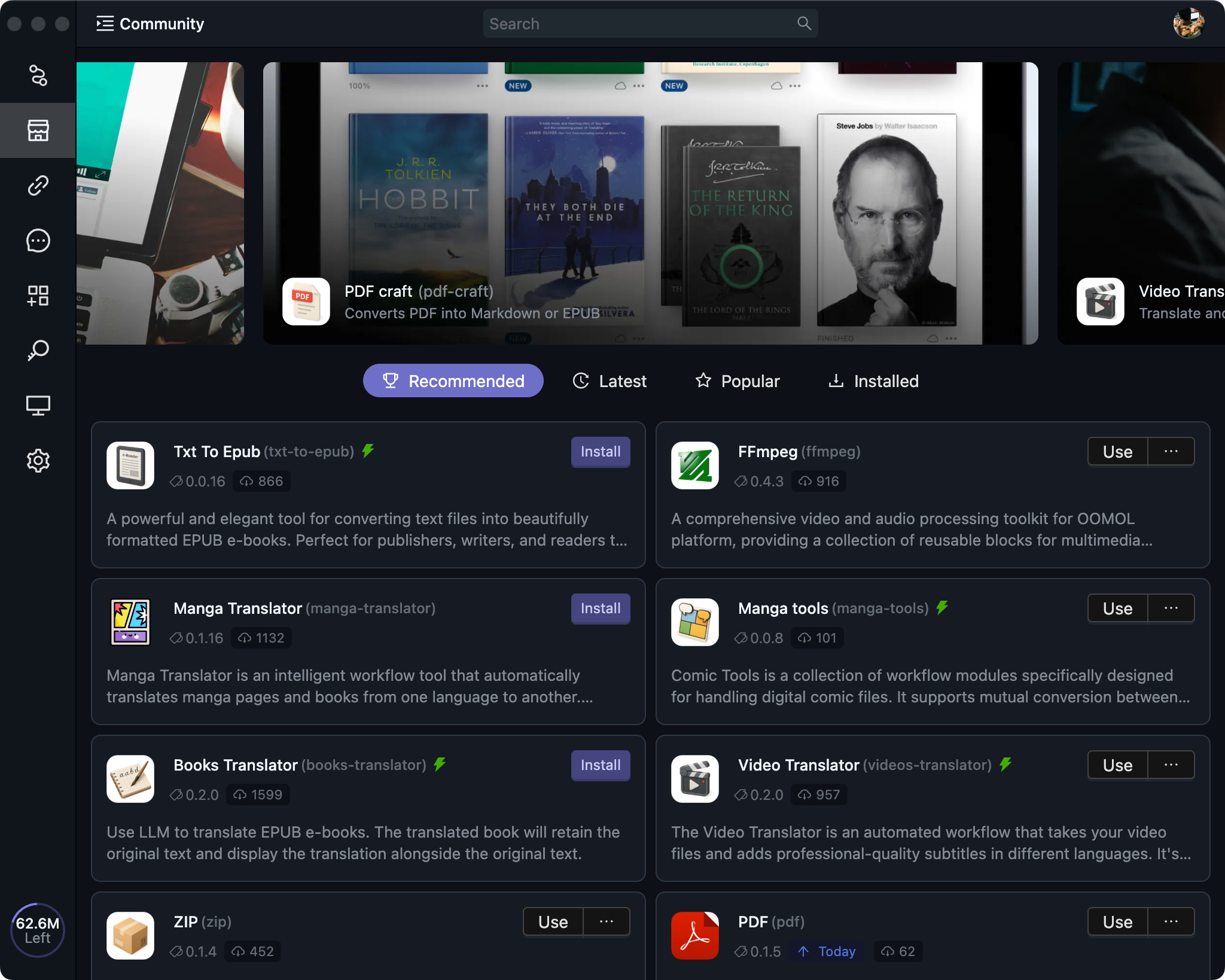

社区与分享

加入我们充满活力的社区,分享您的创作,发现精彩工具,与其他创作者协作。

选择适合你的部署模式

从本地开发到企业级部署,OOMOL 提供灵活的产品形态满足不同场景需求。3 种形态,一套体验。

🖥️

Studio

Studio 软件部署

核心能力

功能完善,使用便捷

适用场景

个人项目调试、团队内快速分享、充分利用闲置 GPU(如装有 Nvidia 4090 PC)

技术特点

本地安装即用,内置容器环境,一键开启互联功能即可作为在线服务器运行

🐳

Headless

Headless 镜像部署

核心能力

自由与安全的企业级选择

适用场景

高自定义 API 服务、自动化工作流部署、私有云环境

技术特点

支持 Docker 等开源基础设施,可深度定制、灵活集成、可控安全

☁️

Cloud

Cloud Serverless 部署

核心能力

官方提供的配套服务,性能优化到极致

适用场景

中小团队快速上线、无需管理基础设施。简单且无心智负担。

技术特点

按需扩缩容、零运维心智负担、极速发布到生产环境

融合 APIs 与大模型

使用一个 OOMOL API Token,即可快速调用多种常用 API 与主流大模型,开发体验更简单、更统一。

- Python

- TypeScript

from oocana import Context#region generated metaimport typingInputs = typing.Dict[str, typing.Any]Outputs = typing.Dict[str, typing.Any]#endregionasync def main(params: Inputs, context: Context) -> Outputs | None:# 融合 API 基础地址api_url = "https://fusion-api.oomol.com/v1/fal-nano-banana-edit/submit"# 大模型基础地址,可使用 openai sdkllm_base_url = "https://llm.oomol.com/v1"# 从 context 获取 OOMOL token(无需手动输入 API key)api_token = await context.oomol_token()return {# "output": "output_value"}

//#region generated metatype Inputs = {};type Outputs = {};//#endregionimport type { Context } from "@oomol/types/oocana";export default async function(params: Inputs,context: Context<Inputs, Outputs>): Promise<Partial<Outputs> | undefined | void> {// 融合 API 基础地址const api_url = "https://fusion-api.oomol.com/v1/fal-nano-banana-edit/submit"// 大模型基础地址,可使用 openai sdkconst llm_base_url = "https://llm.oomol.com/v1"// 从 context 获取 OOMOL token(无需手动输入 API key)const api_token = await context.getOomolToken()// return { output: "output_value" };};

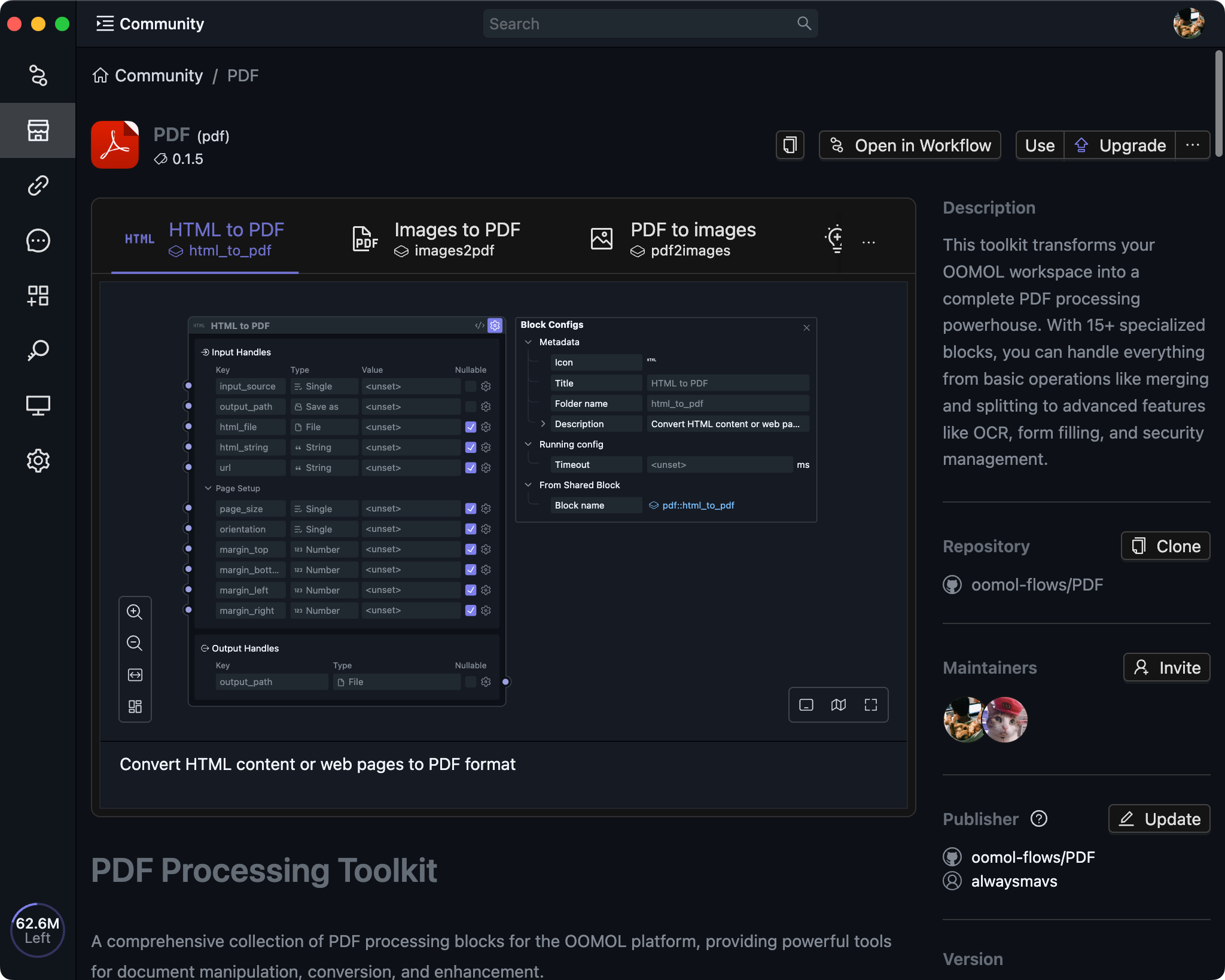

基于 OOMOL 的开源项目:PDF-Craft

基于 OOMOL 构建的旗舰开源项目,体验本地算力的强大优势

📄

PDF-Craft

PDF-Craft 是 OOMOL 官方开源的 PDF 转电子书工具,在 GitHub 上已获得 3000+ Stars。支持本地免费运行、通过 OOMOL 分享给朋友、或使用官方 API 服务 —— 总有适合你的服务。

✓MIT 开源,完全透明

✓基于 DeepSeek OCR,模型先进

✓专业团队维护,开源和服务并行

本地算力,免费私密

- •准备具有 3060 以上显卡的 PC

- •安装 OOMOL Studio 本地免费部署

- •使用小应用或者 Flow 运行

官方服务

按量计费,开箱即用

- ✓官方维护,品质保证

- ✓支持在 PDF-Craft 网站使用

- ✓支持开发者调用 API 服务

立即开始使用

下载 OOMOL Studio —— 让你的想法,立即变成可运行的产品。仅支持 Apple Silicon Mac